Принял решение перепроверить грубо говоря уже знаменитые факты про то, как ведут себя Yandex и Google при запрете страничек в robots.txt. Хотя по сути речь как правило пойдет про Google, так как поведение Yandex’а абсолютно просто и прямолинейно.

Есть 2 варианта:

1) Страничка, странички либо сегменты уже есть и проиндексированы, после этого они закрываются от индексирования в robots.txt

2) Страничка или же категория страничек вначале перекрыта в robots.txt до способности их индексации.

На первый взгляд 2-ой вариант как говорится нет толку осматривать, так как сразу запрещено и «мышь не перескочит, бот не пройдет». Ан, нет – вероятны варианты!

Воспрещение уже проиндексированных страничек web-сайта

Не так давно была замечена потребность перекрыть от индексации вебсайт с соткой тыс. проиндексированных страничек. Почти что вполне, то есть из 90 тысяч осталось единиц 20-50. Yandex в такой ситуации при близком апгрейде непременно устраняет все 88 786 «ненужных» страничек, никак умышленно не уведомляя об этом, то есть ежели вебмастер не разрешила – он знает, что делает.

Google в такой ситуации начинает говорить в Google Webmaster Tools, что “Найдена солидная оплошность…” и нужно будет выяснить, не воспрещены ли актуальные странички веб-сайта в директивах robots.txt. При всем при этом Google не устраняет из индекса запрещенные странички, а продолжает их демонстрировать, включая и сохраненные копии, попросту сохраненные копии не обновляются, а выводятся по состоянию на те даты, когда индексирование разыскиваемых страничек было допустимо.

Формально Google может показаться на первый взгляд правым, поскольку после запрета индексации бот не запрашивает сами странички, а что проиндексировано до запрета, принадлежит индексу Google, но не вебмастеру веб-сайта.

Запрещение индексации свежих страничек

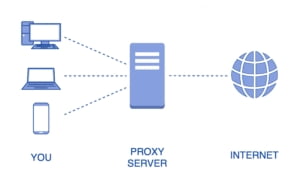

Проверяется просто: 1 либо несколько страничек, выложенных в заблаговременно не разрешенную для индексации директорию, ставим на появившиеся странички гиперссылки на известных Гуглу страничках.

Yandex абсолютно предсказуем – не запрещено, означает разрешено.

Google смахивает на вежливую собаку, которая котлету не ворует, хотя постарается быть к ней очень близко. Поисковик считает, собственно раз гиперссылка есть, значит и страничка присутствует и, ни одного раза не дернув данную страницу с сервера, начинает проявлять гиперссылку на нее в результатах поиска, используя текст гиперссылки и близкий текст в качестве заголовка.

Читайте далее:

Кэш Google — это отличный инструмент для вебмастера, позволяющий сохранить копию содержимого сайта, чтобы использовать ее позже. Его можно использовать для хранения копии содержимого сайта в течение нескольких дней или в течение более длительного периода времени. Вы можете использовать кэш Google, чтобы избавить себя от необходимости повторно загружать содержимое сайта каждый раз, когда Вы его посещаете. Robots.txt — это файл, который Вы можете использовать, чтобы указать Googlebot пометить сайт как «недоступный».